華為雲“算力核彈”全面上線,規模最高可達16萬卡

胡嘉烨

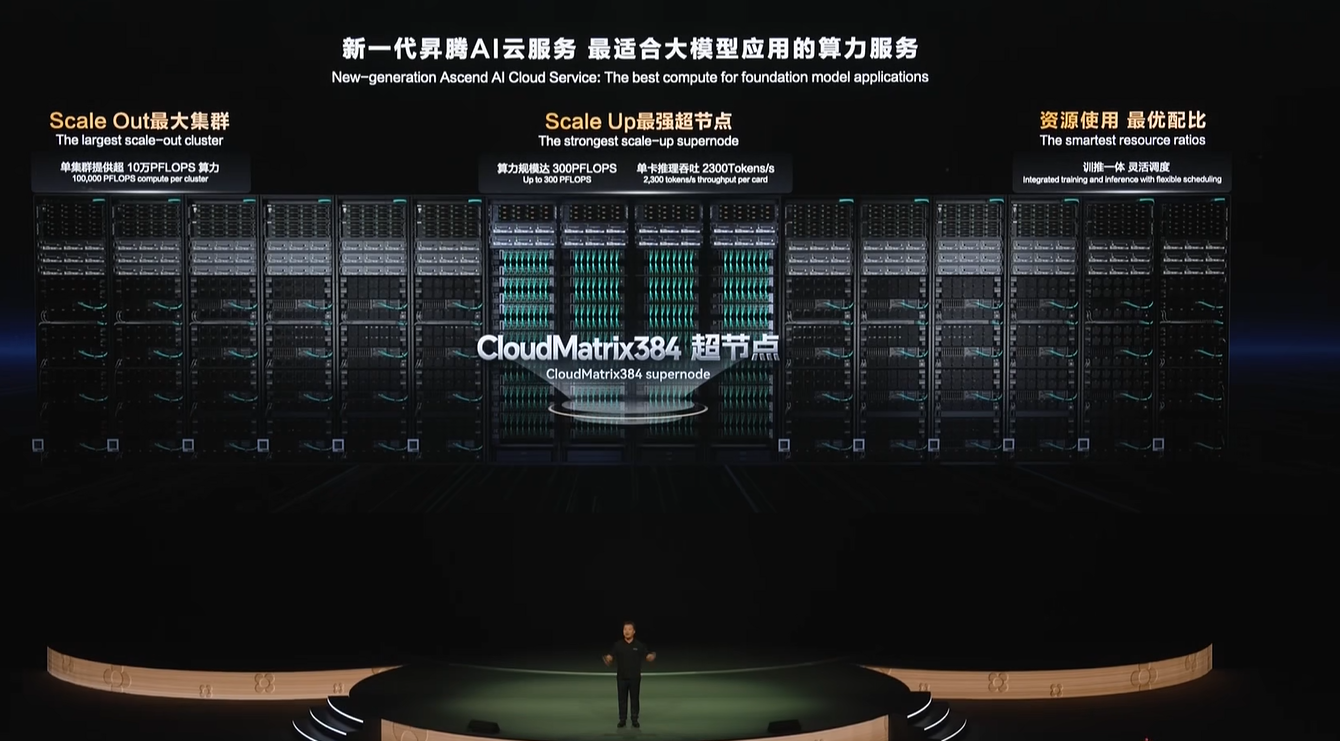

在6月20日舉行的華為開發者大會2025(HDC 2025)上,華為常務董事、華為雲計算CEO張平安宣佈,基於CloudMatrix384超節點的新一代昇騰AI雲服務全面上線,為大模型應用提供澎湃算力。

據介紹,隨着大模型訓練和推理對算力需求的爆炸式增長,傳統計算架構已難以支撐AI技術的代際躍遷。華為雲新一代昇騰AI雲服務基於CloudMatrix384超節點,首創將384顆昇騰NPU和192顆鯤鵬CPU通過全新高速網絡MatrixLink全對等互聯,形成一台超級“AI服務器”,單卡推理吞吐量躍升到2300 Tokens/s。

超節點架構能更好地支持混合專家MoE大模型的推理,可以實現“一卡一專家”,一個超節點可以支持384個專家並行推理,極大提升效率。同時,超節點還可以支持“一卡一算力任務”,靈活分配資源,提升任務並行處理,減少等待,將算力有效使用率(MFU)提升50%以上。

對於萬億、十萬億參數的大模型訓練任務,在雲數據中心,還能將432個超節點級聯成最高16萬卡的超大集羣;同時,超節點還可以支持訓推算力一體部署,如“日推夜訓”,訓推算力可靈活分配,幫助客户資源使用最優。

張平安介紹,新浪與華為雲深度合作,基於CloudMatrix384昇騰AI雲服務,為“智慧小浪”智能服務體系構建了統一的推理平台,底層由昇騰AI算力提供支持。推理的交付效率提升了超過 50%,模型上線速度成倍加快;通過軟硬協同調優,NPU利用率提升超過40%。

硅基流動正在使用CloudMatrix384超節點,為數百萬用户高效提供DeepSeek V3、R1的推理服務。面壁智能使用CloudMatrix384超節點,讓他們的小鋼炮模型的推理業務性能得到了2.7倍提升。

在科研領域,中科院基於CloudMatrix384超節點打造了自己的模型訓練框架,快速構建了中科院AI for Science科研大模型,擺脱了對國外高性能AI算力平台的依賴。

在互聯網領域,360打造的納米AI搜索,為用户提供超級AI搜索服務,對AI算力有極大需求,也已開啓了CloudMatrix384超節點的測試。

當前,昇騰AI雲服務已經為超過1300家客户提供澎湃的AI算力。

在會上,張平安宣佈盤古大模型5.5發佈,自然語言理解NLP、計算機視覺CV、預測、多模態、科學計算五大基礎模型全面升級。他強調,盤古大模型是基於昇騰雲的全棧軟硬件訓練而成的,這標誌着基於昇騰架構可以打造出世界一流大模型。

在NLP大模型方面,全新的718B 深度思考模型是一個由256個專家組成的MoE大模型,在知識推理、工具調用、數學等領域大幅增強,實現能力領先。盤古大模型通過通算掩蓋、全局動態均衡、分組混合專家MoGE等算法,實現了昇騰親和的高效訓推系統,訓練MFU和單卡推理吞吐業界領先。同時,提出了模型親和的詞表、三明治架構、EP-Group負載均衡loss等技術,實現了不弱於業界一流模型的競爭力。

本文系觀察者網獨家稿件,未經授權,不得轉載。