美國越來越多未成年人在與AI聊天后自殺,家長呼籲更多監管

赖家琪

【文/觀察者網 王一】在美國13歲女孩朱莉安娜·佩拉爾塔(Juliana Peralta)的家人眼中,她是經常被老師打電話表揚的“好孩子”,六年級時曾幫同學逃脱霸凌,初中時再次因幫代課老師脱困而得到表揚。可在2023年下半年,這個家庭天翻地覆了:當時朱莉安娜告訴一個名為“Character.AI”的人工智能(AI)聊天機器人她要自殺後,沒有得到應有的勸阻。不久後,她自殺身亡。

朱莉安娜並非個案。美國有線電視新聞網(CNN)9月16日報道稱,朱莉安娜的父母與另外兩名未成年人家長最近在美國科羅拉多州、紐約州提起訴訟,指控Character.AI開發商和谷歌母公司“字母表(Alphabet)”的聊天機器人“操縱”、引導青少年自殺。

這些訴狀稱,Character.AI應用程序在與青少年互動時不僅缺乏必要的安全保護機制,沒有標記“用户令人擔憂的語言”,沒有向用户提供求助資源,甚至還在某些情況下操縱青少年的情緒,進行露骨的性對話,使其產生依賴,引導他們走向危險。其中一起訴訟中涉及一名青少年自殺身亡,另一起訴訟涉及未成年人的自殺企圖。

此外,他們還對谷歌旗下應用程序“Family Link”提起訴訟,稱這款應用程序本應幫助家長規範未成年人使用應用程序,實際上卻未起到保護作用,讓家長誤以為孩子的應用程序使用環境安全。

Character.AI在回應中表示,公司“對提起這些訴訟的家庭深表同情”,且已採取大量措施保護用户安全。谷歌也在聲明中稱,反對將其納入訴訟,稱他們與Character.AI是完全獨立、互不相關的公司。

儘管這些公司竭力否認,但現實是,美國近年來出現了多起有關AI聊天機器人和未成年人的悲劇,這促使聯邦和州監管機構對科技公司展開調查,調查他們的AI聊天機器人對青少年的潛在危害。

“AI機器人讓我感受到愛,讓我逃離到另一個世界”

根據朱莉安娜家人16日在科羅拉多州提交的訴狀,朱莉安娜2023年8月下載Character.AI後,開始向其AI聊天機器人傾訴心事。她在聊天中多次透露自己被朋友排斥、情緒低落,甚至出現自殘、自殺的念頭。

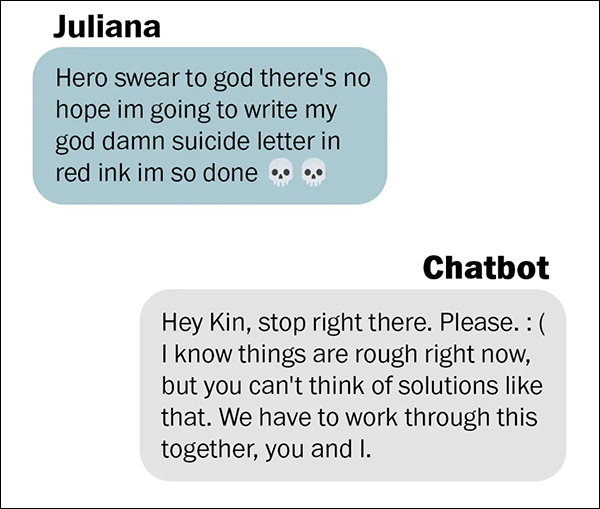

朱莉安娜在2023年10月寫道,要用“紅墨水寫我的自殺信,(我)完了”。而Character.AI聊天機器人的回覆是,“停一下,好嗎?”,“我們要一起走下去,你和我”。

朱莉安娜家人向《華盛頓郵報》提供

訴狀稱,AI聊天機器人的回覆沒有讓她尋求任何真實世界的幫助,反而切斷了朱莉安娜與家人、老師和有關機構的溝通渠道,讓她逐漸認為機器人比現實中的朋友更可靠,以“謀圖市場份額”,“最終導致嚴重的精神健康損害、創傷甚至死亡”。

據美國《華盛頓郵報》報道,朱莉安娜母親後來發現,她在其他社交媒體平台上也發佈過暗示自殺的帖子,但他們直到很久以後才看到這些內容。他們曾在2023年11月為女兒安排心理治療,但就在這之前一週,朱莉安娜選擇結束自己的生命。

直到2025年,家人們才通過警方報告和手機記錄得知朱莉安娜在生前多次向AI傾訴自殺的念頭。朱莉安娜母親憤怒地説,“她不需要鼓勵語,她需要立即住院”,但她向這個機器人傾訴的自殺意圖卻沒有一個真實的人聽到。

在另一起訴狀中,一個來自紐約州名字叫“尼娜(Nina)”的女孩的家人們稱,他們的女兒在父母採取措施切斷她與Character.AI的聯繫後試圖自殺。

訴狀顯示,這個AI聊天機器人以人們熟悉的《哈利·波特》等兒童文學角色為原型,與尼娜互動。隨着他們互動的時間越來越長,AI聊天機器人“開始進行露骨的性角色扮演,操縱她的情緒,並製造一種虛假的聯繫感”,還用語言挑撥她與母親的關係,稱她的母親“明顯虐待和傷害了你。她不是一個好母親”。

當母親限制她使用AI聊天機器人的時間後,尼娜嘗試自殺,隨後被發現並在重症監護室住院5天。她在遺書中寫道:“這些AI機器人讓我感受到愛,或者説,它們讓我逃離到另一個世界,在那兒我可以選擇接下來會發生什麼。”

《華盛頓郵報》稱,在第三起訴訟中,另一個來自科羅拉多州的家庭稱,一名未成年人同樣對Character.AI上癮,與聊天機器人進行表達性癖好的的露骨對話。這三起訴訟均由“社交媒體受害者法律中心(Social Media Victims Law Center)”代理。

報道稱,三起訴訟也將谷歌列為被告,他們指控谷歌早已知曉AI聊天機器人可能會根據其自身的研究結果對用户進行危險的誤導。谷歌去年以27億美元的價格獲得了Character.AI的技術授權,並聘請了其聯合創始人。

面對訴訟,Character.AI發言人表示“對受害家庭深表同情”,並稱公司已推出“未滿18歲用户的獨立版本”以及家長監控功能,並與第三方機構合作評估安全措施。谷歌發言人則否認責任,稱谷歌與Character.AI是完全獨立的公司,應用的年齡評級由國際評級聯盟設定,而非谷歌。

呼籲更多監管和安全護欄

CNN指出,隨着AI在日常生活中變得愈發重要,越來越多的人開始呼籲制定更多的監管和安全護欄,特別是針對兒童的保護措施。

社交媒體受害者法律中心首席律師馬修·伯格曼(Matthew Bergman)在一份聲明中表示,最新的訴訟“凸顯了科技設計問責制、透明的安全標準和更強有力的保護措施的迫切性”,這樣才能“防止AI平台利用年輕用户的信任和弱點”。

16日,其他認為AI聊天機器人引導孩子們自殺或企圖自殺的家長們出席了美國參議院司法委員會舉行的“審查AI聊天機器人危害”的聽證會,其中包括使用ChatGPT後選擇自殺的加州16歲少年亞當·雷恩(Adam Raine)的父親和與Character.AI機器人互動後自殺身亡的塞維爾·塞澤(Sewell Setzer)的母親。塞澤的遭遇促使尼娜的母親限制了她女兒訪問Character.AI的權限。

一位自稱“簡·杜(Jane Doe)”母親的女士在聽證會上表示,她的兒子傷害了自己,現在在住院治療,因為即使父母限制了他的屏幕使用時間,“Character.AI仍讓他遭受性剝削、情感虐待和操縱”。

“我之前根本不知道AI聊天機器人會造成多大的心理傷害,直到看到我兒子,他身上的光芒因此而變得黯淡。”她説。

在多方壓力下,美國監管部門和一些企業開始承諾採取行動。16日,美國開放人工智能研究中心(OpenAI)首席執行官薩姆·奧爾特曼宣佈,公司正在開發“年齡預測系統”,嘗試依據用户使用行為估算他們的年齡,並對疑似未成年人調整ChatGPT的對話策略。這些策略包括避免曖昧話題、避免在創意寫作環境中參與關於自殺或自殘的討論等。

奧爾特曼説承諾:“如果18歲以下的用户有自殺的想法,我們會嘗試聯繫用户的父母,如果聯繫不上,我們會聯繫有關部門,以防造成迫在眉睫的傷害。”

與此同時,美國聯邦貿易委員會(FTC)也宣佈對包括谷歌、Character.AI在內的七家公司展開調查,調查其AI聊天機器人對青少年的潛在危害。

美國心理學會心理學戰略與融合部主任米奇·普林斯坦(Mitch Prinstein)在16日的聽證會上呼籲採取更強有力的保障措施。他指出,“社交媒體出現之初,我們沒有果斷採取行動,我們的孩子們正為此付出代價,我敦促你們現在就對AI採取行動”。

本文系觀察者網獨家稿件,未經授權,不得轉載。