460萬美元訓練出頂級大模型? 月之暗面楊植麟親自回應

陈济深

(文/陳濟深 編輯/張廣凱)

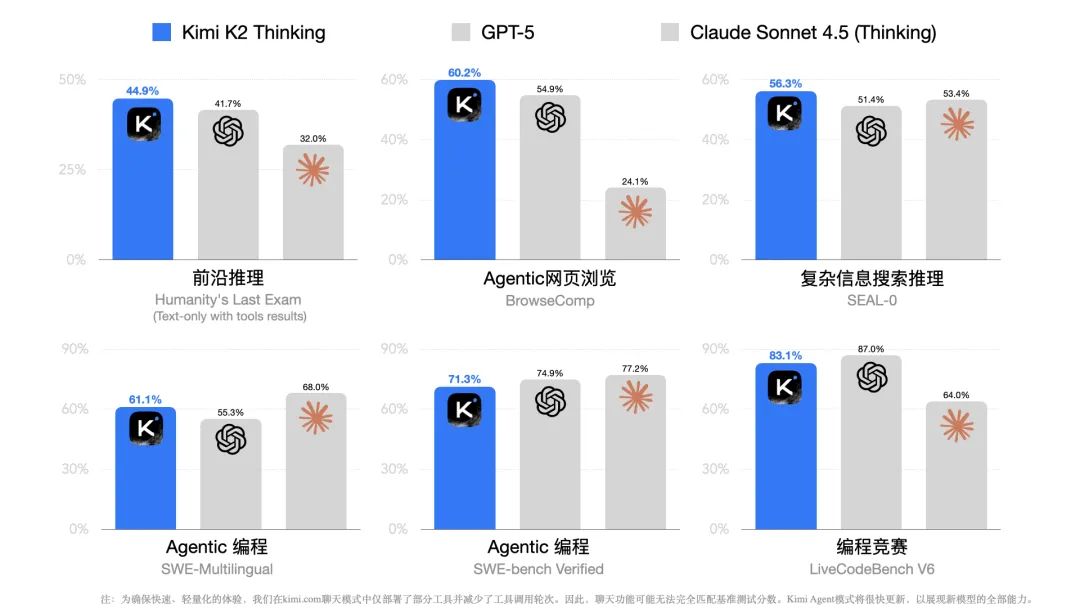

11月6日,月之暗面發佈最新模型Kimi K2 Thinking,在Humanity’s Last Exam、TAU-Bench等重要基準測試中,超越GPT-5、Claude 4.5等全球最強開源乃至閉源模型。

在Kimi發佈更新的同一天,英偉達CEO黃仁勳關於“中國將贏下人工智能全球競賽”的最新言論更是讓這個中國大模型吸引了全世界的關注。

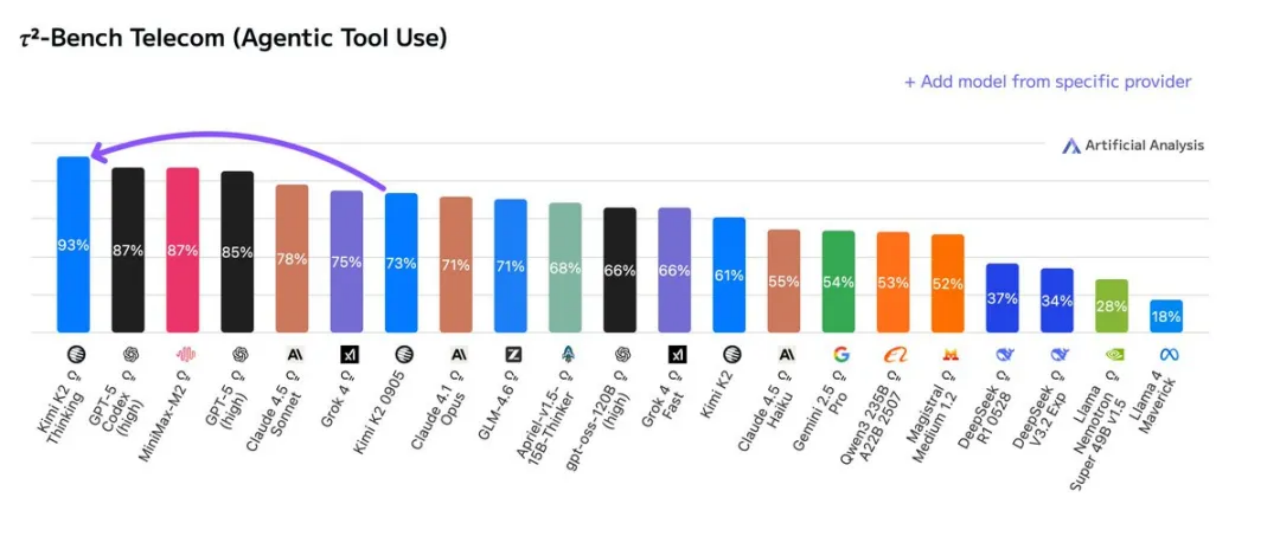

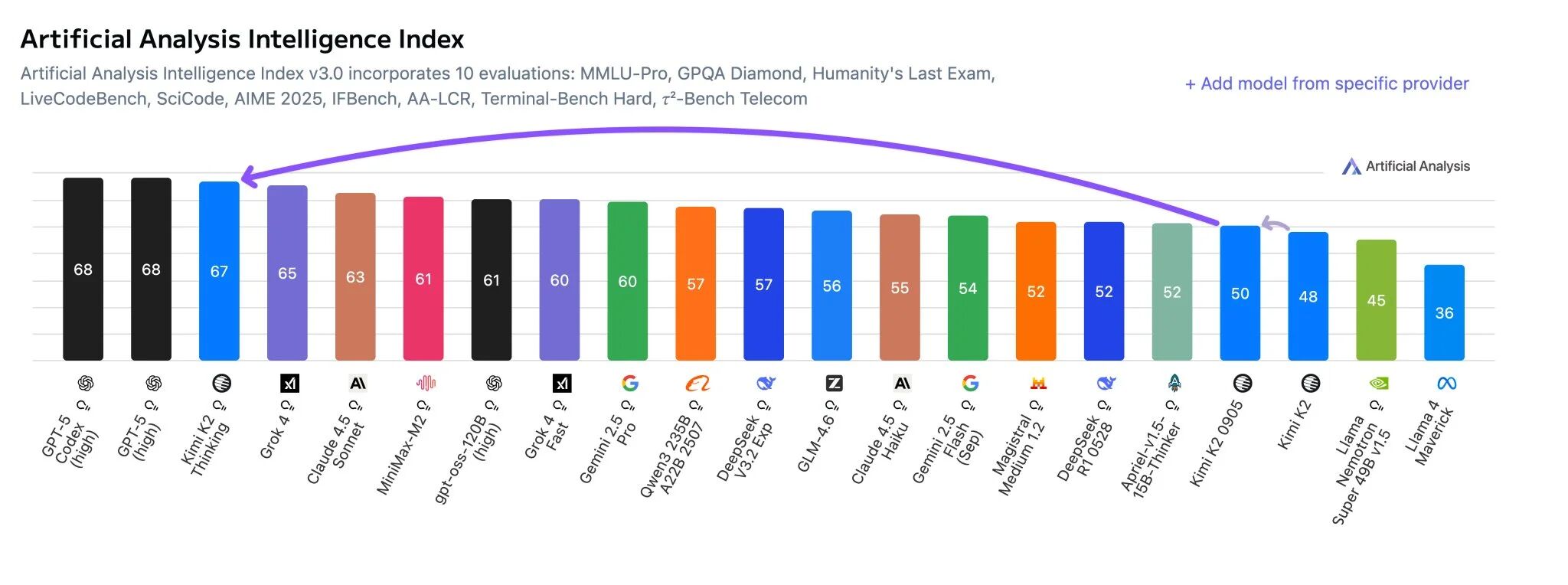

在專業機構 Artificial Analysis 智能體工具的調用測試中,Kimi K2 Thinking的得分達到93%,是目前第三方機構測量到的最高分;在智能指數中,則以67分排名第3,僅次於GPT5。

K2 Thinking在幾個關鍵領域實現了重大突破:首先是採用了“超稀疏MoE”架構,用極高的效率獲得了萬億級模型的強大知識;其次是實現了“原生INT4量化”,在訓練中就解決了精度與效率的矛盾,大幅提升了推理速度並降低了硬件門檻;最關鍵的是,它在“智能體”(Agent)工具調用能力上實現了質的飛躍,在衡量“AI數字員工”能力的TAU-Bench測試中登頂。

在發佈後僅僅48小時不到,Kimi K2 Thinking下載量已超過5萬,成為人工智能全球最大開源社區Hugging Face最熱門的開源模型。

“這是另一個DeepSeek時刻嗎?”Hugging Face聯合創始人Thomas Wolf在個人社交賬號上敲下評論。海外的開源社區和科技媒體上,開發者對Kimi K2 Thinking的讚譽也紛至沓來。

除了性能上的突破,一則傳聞的出現更是讓Kimi引發了市場的強烈關注。CNBC報道稱,Kimi K2的訓練成本僅為460萬美元。

這也意味着,Kimi僅用了OpenAI訓練GPT5不到1%的成本就訓練出了不輸GPT5的全球頂級大模型,而33億美元估值的月之暗面比起目前估值突破5000億,旨在衝擊萬億美元市值的OpenAI更是可以忽略不計,而就是這個中國的“小”玩家卻用極低的成本搓出了一個頂級模型。

面對這個震撼的對比,K2 Thinking在引發市場關注的同時,也引發了部分人羣的質疑,Kimi新模型的訓練成本到底是多少?Kimi這次登頂是不是跑分刷榜?Kimi不做多模態模型是不是就是為了刷榜而不是應用?

11月11日深夜,月之暗面月之暗面聯合創始人兼CEO楊植麟,以及聯合創始人周昕宇和吳育昕,在Reddit舉辦了一場AMA (Ask Me Anything,問我任何事),回應了諸多外界的關注內容。

從回答陣容來看,楊植麟用了一個叫“ComfortableAsk4494”的賬號來直接在線答疑。

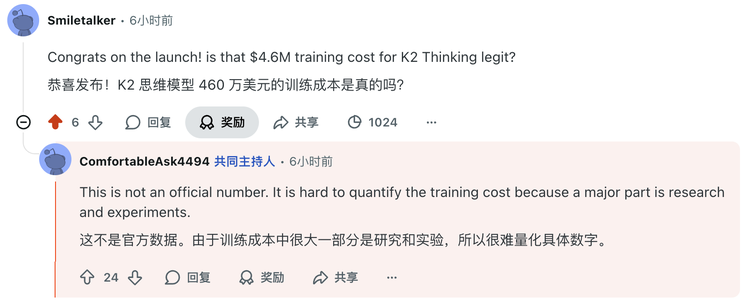

對於大家最關心的訓練成本問題,楊植麟直接坦言460萬美元不實。

他表示:“這不是官方數據。由於訓練成本中很大一部分是研究和實驗,所以很難量化具體數字。”

而對於優先聚焦文本模型是為了短期刷榜,還是準備持續深耕文本領域的問題,楊植麟則明確表示,“訓練視覺語言模型需要時間獲取數據和調整訓練,所以我們決定先發佈一個文本模型。”

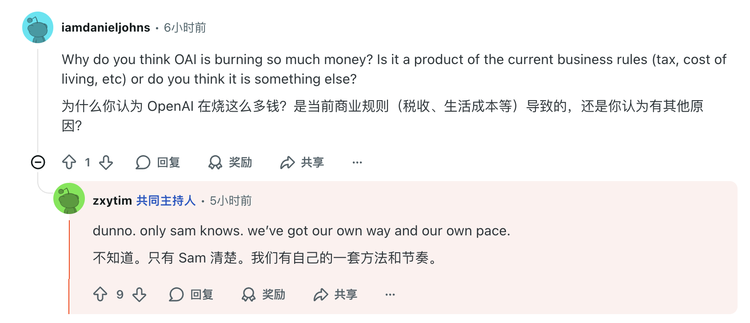

甚至有網友問到為什麼OpenAI會燒那麼多錢,楊植麟更是坦言“我不知道”。

還有網友質疑,Kimi K2 Thinking是否經過專門訓練,以在HLE這一基準測試中取得好成績?它的高分似乎與實際使用中的智能水平不太相符。

楊植麟回應道,Kimi K2 Thinking在提升智能體推理能力方面取得了一些進展,使其在HLE測試中得分較高。月之暗面正在努力進一步提升其通用能力,以便在更多實際應用場景中充分發揮智能的作用。

另有網友問道:“為何K2 Thinking能在一次推理中保持如此長的思維鏈,而GPT-5不行?”

楊植麟解釋道:“我認為推理時間取決於API吞吐,而推理token的數量取決於模型訓練方式。我們在訓練Kimi K2 Thinking時傾向於使用更多的思考token以獲得最佳效果。我們的Turbo API會更快,同時Kimi K2 Thinking原生採用INT4,這也提升了推理速度。

Kimi K2系列模型不阿諛奉承、直接的文風在AI界算是一股清流,有不少網友認可這種風格。吳育昕稱,這種寫作風格是模型後訓練數據和評估的重要組成部分。

月之暗面三位聯合創始人還集中回應了與模型服務、開源等相關話題的疑問。

有網友稱,Kimi在自己的公司已經成為主要的測試模型,但生產環境會切換到美國本土的模型。這主要是因為領導層擔心Kimi是“中國大模型”,可能存在一些風險。

這位網友還分享,自己很喜歡使用Kimi App,自己一位在亞馬遜工作的朋友也很喜歡這一應用,但由於亞馬遜有規定必須使用自家的AI助手,禁止在工作場合使用其他主流的AI助手App。網友擔心,隨着Kimi逐漸變得知名,她會不會再也無法在工作場合中使用呢?

吳育昕回應稱:“雖然被封禁往往超出我們的控制範圍,但開源該模型有望成為消除部分顧慮的有效途徑(企業可以自行部署)。我們希望看到一個更加信任的世界,但這需要時間。”

上下文一直是影響AI模型在生產環境應用的重要因素。目前,Kimi K2 Thinking最大支持256K的上下文,有網友反饋這對大型代碼庫而言並不算大。

楊植麟稱,月之暗面應該能在未來的版本中增加上下文長度。

還有網友希望月之暗面能將模型上下文窗口提升到100萬個token,周昕宇回覆道,月之暗面之前已嘗試過100萬個token的上下文窗口,但當時的服務成本太高,未來他們會重新考慮更長的上下文窗口。

當被問及有無AI瀏覽器的開發計劃時,周昕宇十分犀利地回覆道:要做出更好的模型,並不需要再去套一層新的Chromium殼。

楊植麟稱,月之暗面目前將專注於模型訓練,但會不斷更新kimi.com ,使其包含最新功能。

還有不少網友提到,希望月之暗面能推出規模更小的模型。楊植麟稱,Kimi-Linear-48B-A3B-Instruct就是月之暗面發佈的小型模型之一,未來他們可能會訓練更多模型並添加更多功能。

目前,Kimi已經提供了編程訂閲方案,這一計費方式是基於API請求次數,有網友稱這種模式導致資源消耗偏高。月之暗面回應稱,API請求次數計費能讓用户看到費用明細,同時也更符合企業的成本結構。不過,他們會盡快找到更好的方案。

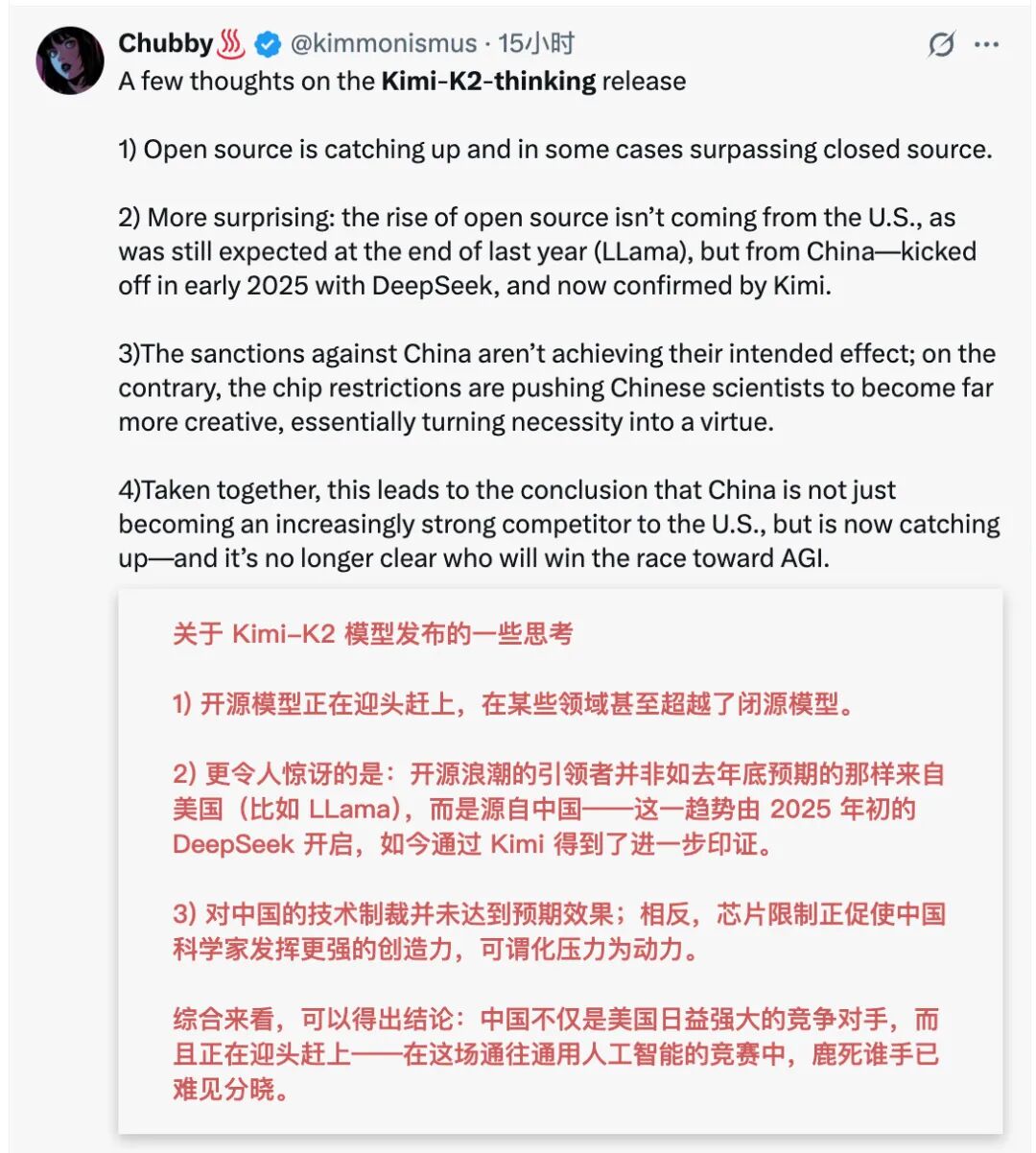

從社區中海外開發者的熱烈提問和尖鋭反饋可以看出,以Kimi系列為代表的中國模型正受到前所未有的關注。月之暗面此次在Reddit平台的公開問答,集中回應了全球網友對Kimi技術細節的大量興趣和疑問。這種關注背後,也折射出全球開發者對中國AI創新能力的認可。