美團“Building LLM ”進展首度曝光:發佈並開源LongCat-Flash-Chat 輸出成本低至5元/百萬token

【環球網科技報道 記者 李文瑤】9月1日,美團宣佈 LongCat-Flash-Chat 正式發佈,在Github、Hugging Face 平台開源,並同步上線官網。

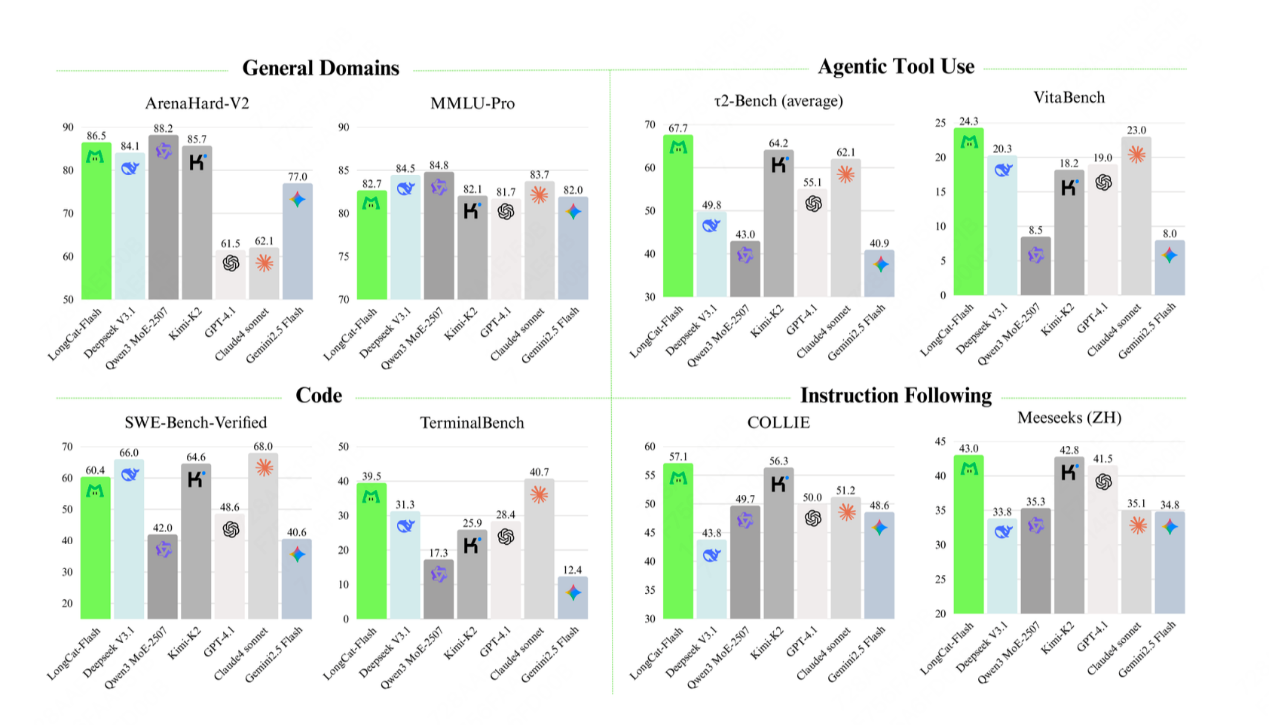

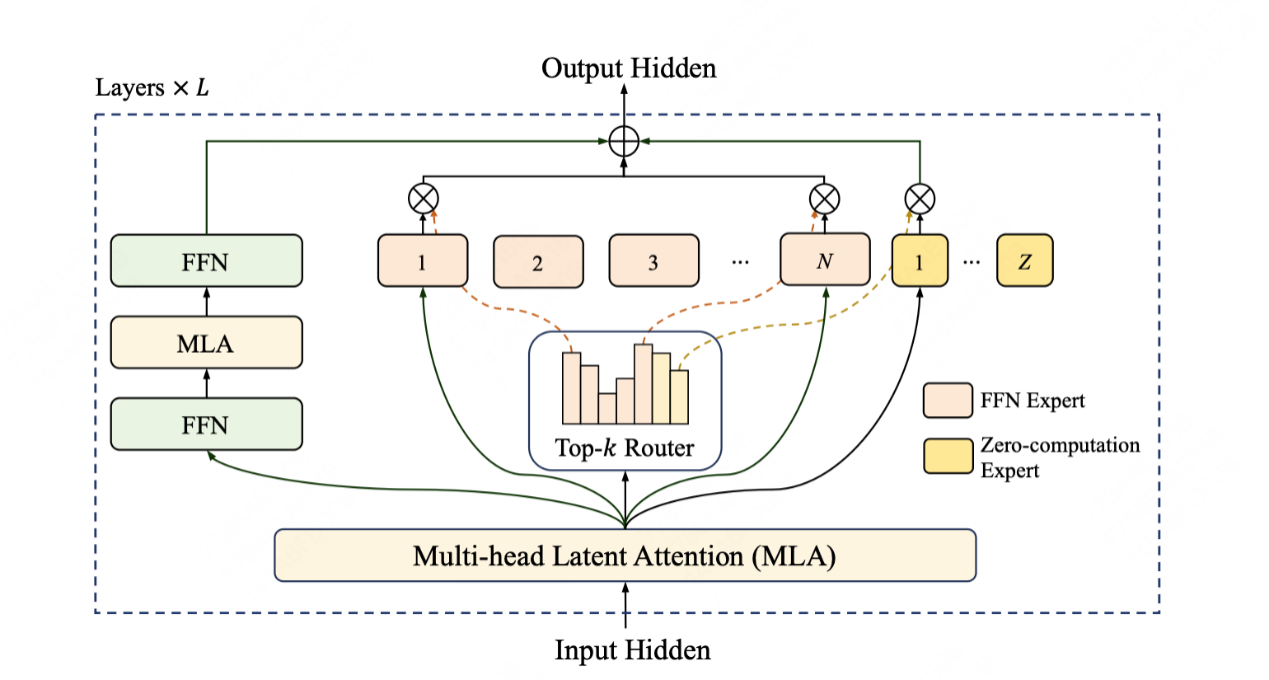

據悉,LongCat-Flash 採用創新性混合專家模型(Mixture-of-Experts, MoE)架構,總參數 560B,激活參數 18.6B-31.3B(平均 27B),實現了計算效率與性能的雙重優化。根據多項基準測試綜合評估,作為一款非思考型基礎模型,LongCat-Flash-Chat 在僅激活少量參數的前提下,性能比肩當下領先的主流模型,尤其在智能體任務中具備突出優勢。此外,因為面向推理效率的設計和創新,LongCat-Flash-Chat 具有明顯更快的推理速度,更適合於耗時較長的複雜智能體應用。

今年以來,美團 AI 進展頻傳,發佈了 AI Coding Agent 工具 NoCode 、AI 經營決策助手袋鼠參謀、酒店經營的垂類 AI Agent 美團既白等多款 AI 應用。公司方面曾表示,其 AI 戰略會建立在三個層面:AI at work、AI in products 以及 Building LLM,此次模型開源是其 Building LLM 進展的首度曝光。

具體來看,LongCat-Flash 模型在架構層面引入“零計算專家(Zero-Computation Experts)”機制,總參數量 560B,每個token 依據上下文需求僅激活 18.6B-31.3B 參數,實現算力按需分配和高效利用。為控制總算力消耗,訓練過程採用 PID 控制器即時微調專家偏置,將單 token 平均激活量穩定在約 27B。

此外,LongCat-Flash 在層間鋪設跨層通道,使MoE的通信和計算能很大程度上並行,極大提高了訓練和推理效率。配合定製化的底層優化,LongCat-Flash 在 30 天內完成高效訓練,並在 H800 上實現單用户 100+ tokens/s 的推理速度。LongCat-Flash 還對常用大模型組件和訓練方式進行了改進,使用了超參遷移和模型層疊加的方式進行訓練,並結合了多項策略保證訓練穩定性,使得訓練全程高效且順利。

針對智能體(Agentic)能力,LongCat-Flash 自建了 Agentic 評測集指導數據策略,並在訓練全流程進行了全面的優化,包括使用多智能體方法生成多樣化高質量的軌跡數據等,實現了優異的智能體能力。

通過算法和工程層面的聯合設計,LongCat-Flash在理論上的成本和速度都大幅領先行業同等規模、甚至規模更小的模型;通過系統優化,LongCat-Flash 在 H800 上達成了 100 token/s的生成速度,在保持極致生成速度的同時,輸出成本低至5元/百萬token。