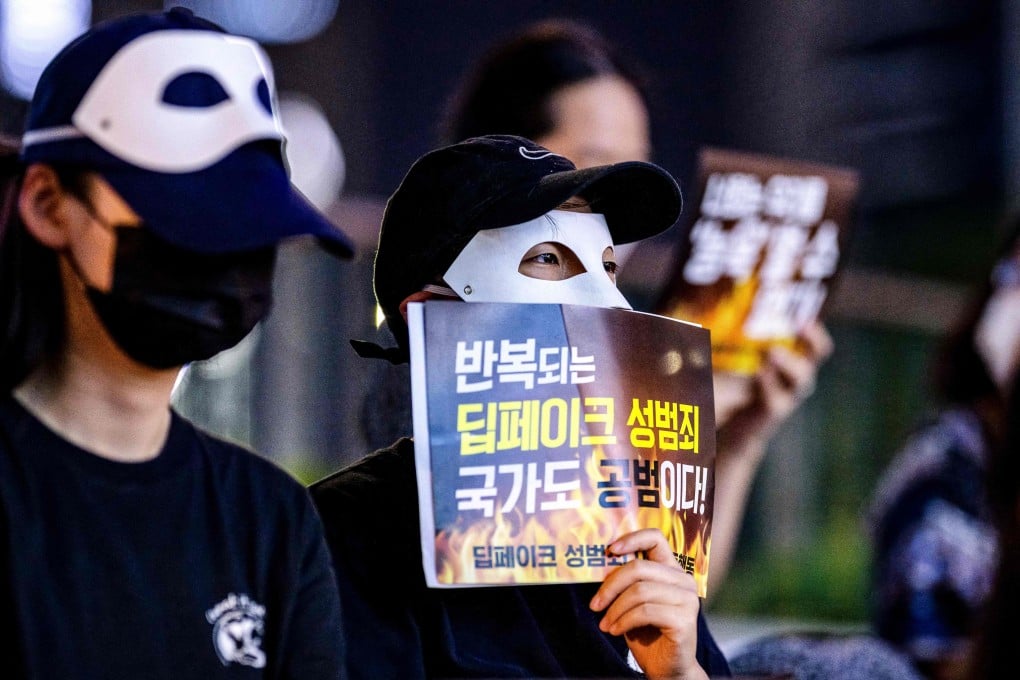

韓國直面AI性犯罪的無形創傷:“法律未能保護我” | 南華早報

Lee Seung-ku

當韓國研究生露瑪*2021年通過Telegram收到自己的AI換臉淫穢圖片時,她連續數週無法入睡。這些圖片是基於她公開資料照片用人工智能技術合成的,而警方卻告知她無能為力。31歲的露瑪對《本週亞洲》表示:“我感到孤立無援,不得不自己收集證據甚至指認罪犯…感覺像在替警方辦案。”

當韓國研究生露瑪*2021年通過Telegram收到自己的AI換臉淫穢圖片時,她連續數週無法入睡。這些圖片是基於她公開資料照片用人工智能技術合成的,而警方卻告知她無能為力。31歲的露瑪對《本週亞洲》表示:“我感到孤立無援,不得不自己收集證據甚至指認罪犯…感覺像在替警方辦案。”

嫌疑人樸姓大學校友共鎖定61名女性,通過Telegram散佈了1852張AI生成的淫穢圖片。樸某及其同夥姜某自稱"照片合成專家"。

去年9月,樸某和姜某分別被判10年與4年監禁。二人提起上訴後,首爾高等法院上週五考慮到已與部分受害者達成和解,將刑期分別減為9年和3年6個月。

露瑪的個案折射出韓國數字性犯罪激增現象。韓國性別平等與家庭部數據顯示,2024年此類案件超1.8萬起,同比增加12.7%。

韓國504所學校中超過800名學生和教職員工僅在一個月內就成為了深度偽造色情犯罪的受害者。照片:Shutterstock

韓國504所學校中超過800名學生和教職員工僅在一個月內就成為了深度偽造色情犯罪的受害者。照片:Shutterstock

尤其令人擔憂的是這些犯罪中深度偽造技術的爆炸式增長,僅去年此類案件就上升了227%。深度偽造利用人工智能模仿一個人的面部、聲音或行為——受害者常被植入偽造的色情內容中。